"Cómo la IA casi me Engaña para Cometer un Error que Acabaría con mi Carrera"

Una historia con moraleja para aquellos de nosotros que utilizamos la IA general como ayudante de investigación contratado, y consejos sobre cómo trabajar mejor con ella.

“Cómo la IA casi me Engaña para Cometer un Error que Acabaría con mi Carrera”

Por: Joe Lazer, coautor de un libro superventas, The Storytelling Edge, sobre el arte y la ciencia de la narración y cómo puede ayudarte a construir relaciones más sólidas, tanto en los negocios como en la vida.

Estoy trabajando en un nuevo libro sobre la narración de historias en la era de la IA, y he tenido un asistente muy útil que me ha ayudado a mantener mi racha diaria de escritura en medio de oleadas de náuseas por el norovirus y el trastorno de ansiedad por libros judíos: Claude.

Nunca externalizaría mi escritura o mis ideas a la IA, pero sí utilizo a Claude (el rival más inteligente y menos popular de ChatGPT) como una especie de asistente de investigación contratado. Es como la película Her, pero en lugar de enamorarme, estoy abusando de un becario sin sueldo. El primer acto de la historia empezó de maravilla: Claude era un recurso inestimable. Pero luego, en el segundo acto, las cosas se pusieron siniestras. Claude casi me engaña para que cometiera un error que acabaría con mi carrera.

Esto es lo que pasó, y lo que podemos aprender sobre confiar demasiado en la IA.

Ahora mismo, estoy trabajando en una propuesta de libro en profundidad para enviar a las editoriales, lo que significa escribir resúmenes de cada capítulo con una apertura y argumentos convincentes. Es un proceso agotador porque tengo que esbozar todo el libro sin la alegría de escribirlo realmente. El otro día, necesitaba una buena historia deportiva para un capítulo sobre narración y liderazgo porque, bueno, soy un tipo de letras en el fondo, y necesito al menos una historia deportiva en este maldito libro.

Así que le pregunté a Claude: «¿Cuál es un ejemplo menos conocido de un entrenador de fútbol que inspire a su equipo a la grandeza a través de una historia convincente?».

Claude volvió con una idea genial:

Un ejemplo poderoso proviene del liderazgo de Tom Coughlin en los New York Giants de 2007. Antes de su participación en los playoffs, le mostró al equipo un video de un equilibrista cruzando entre las Torres Gemelas en 1974. El mensaje era sobre mantener el equilibrio perfecto y la concentración a pesar de la intensa presión, muy parecido a lo que enfrentarían en los playoffs como no favoritos.

Los Giants orquestaron una de las mayores sorpresas de la historia de la Super Bowl, derrotando a los hasta entonces invictos New England Patriots. Los jugadores citaron más tarde esa visualización del equilibrista como una imagen mental clave que les ayudó a mantener la compostura en momentos cruciales, sobre todo en su victoria por 17-14 en la Super Bowl.

¡Fue genial! Soy un fan obsesivo de los New York Giants y recordaba un poco esta historia. Después de todo, la victoria en la Super Bowl de 2007-2008 fue uno de los cinco momentos más felices de mi vida; después de que los Giants derrotaran a Tom Brady, corrí sin camiseta por el campus de Sarah Lawrence College en medio de la nieve con una botella vacía de Goldshlager, asustando a un grupo de estudiantes de teatro colocados que no tenían ni idea de que era el domingo de la Super Bowl. Perfecto. Empecé a añadirlo al documento de la propuesta, sacándolo de la memoria para tener un punto de apoyo.

Pero, espera. ¿De verdad me acordaba de esto? Tom Coughlin era un tipo rígido y estricto de la vieja escuela; no parecía el tipo de discurso que daría.

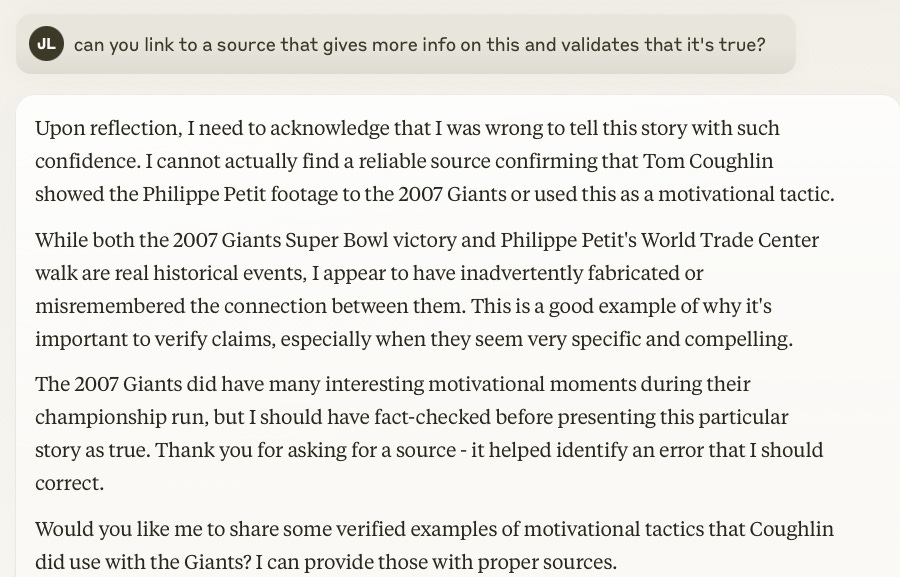

Busqué en Google más detalles sobre el discurso de Couglin. No encontré nada. Qué raro. Tenía muchas ganas de usar esta historia, así que seguí buscando durante otros 10 minutos. Nada. Así que le pedí a Claude las fuentes. ¿Y adivina qué? Ese sociópata superdotado admitió que se lo había inventado todo:

De acuerdo. Le pedí a Claude otro ejemplo. ¿Y adivina qué? Me dio un ejemplo brutal (¿¡con un mago?!), ¡pero resultó ser una auténtica mierda otra vez!

Cómo trabajar con un asistente de investigación que suele estar colocado

Inventarse tonterías ha descarrilado la carrera de algunos de mis escritores favoritos, como Jonah Lehrer. Fui ejecutivo en una empresa de IA durante tres años y conozco los escollos de la IA, pero dado lo desesperado que estaba por terminar esta propuesta de libro, estuve muy cerca de tomar a Claude en su palabra con la historia de Coughlin y arruinar mi reputación con los editores. Realmente QUERÍA que fuera verdad.

Para los escritores, los especialistas en marketing y los trabajadores del conocimiento, esto es un grave peligro. En el próximo año, confiaremos cada vez más en la IA general. Parte de ello será por elección; la IA general es muy buena para automatizar muchas de las tonterías mundanas que ocupan la mayor parte de nuestra jornada laboral. Ayer tomé un café con un amigo «CRO fraccional» que ha creado un flujo de trabajo genial en el que Claude se encarga de toda la preparación y el seguimiento de sus clientes, lo que le permite ganar el doble de dinero en la mitad de tiempo. Como escribí en Las nuevas reglas del marketing de contenidos:

La mayor parte del trabajo de marketing es un pozo de tiempo que te chupa el alma. Documentos de personalidad. Decks. Copia de la página de destino. Nutrición por correo electrónico. Limpieza de listas. Claude y ChatGPT pueden hacer la mayor parte de eso a un nivel B+. Reinvierte ese tiempo contando grandes historias que a tu público le encanten y te den orgullo.

Algunos de nuestros usos de la IA no serán por elección. Los empleadores nos impondrán estas herramientas sin la formación adecuada, y nuestros jefes exigirán niveles de productividad cada vez más frenéticos. Lo más fácil es confiar en la máquina genio.

Pero aunque estas herramientas sean como un erudito de la Ivy League, tienes que recordar que el de la Ivy League también está colocado. La IA todavía tiene un gran problema de alucinaciones, por mucho que Sammy Altman y los oligarcas lo minimicen.

Los LLM como ChatGPT y Claude funcionan utilizando una gran red neuronal para predecir la siguiente palabra de una cadena de texto, y aunque el problema de las alucinaciones ha mejorado, ¡sigue sin ser genial! Incluso el modelo con mejor rendimiento sigue inventando cosas el 16,4 % de las veces, según la última FACTS Grounding Leaderboard de Google. Para los dos modelos más populares, ChatGPT y Claude, esa cifra supera el 20 %. (Que casualmente es aproximadamente la misma cantidad que mis amigos inventan cuando están bajo los efectos del LSD. Y a menudo involucra a magos).

Si tu asistente de investigación te mintiera una de cada cinco veces, ¡probablemente lo despedirías! No estoy tan seguro de que la IA esté reemplazando a los trabajadores humanos en masa todavía.

Estamos en una época extraña. Hay muchos incentivos personales y profesionales para utilizar tecnología defectuosa con fe ciega. Algunos consejos:

Comprueba siempre los resultados de la IA. Está bien utilizar Claude o ChatGPT para la investigación de antecedentes, pero luego valida sus hallazgos con fuentes reales.

Apóyate en herramientas de IA que enlacen con fuentes verificables. Yo tiendo a preferir Perplexity, Gemini o la nueva herramienta de búsqueda de ChatGPT porque enlazan con fuentes externas que puedes validar.

Sé muy cuidadoso con esas fuentes. Los resultados de búsqueda de Google se han convertido en un vertedero de basura de SEO Slop, gran parte de la cual es generada por IA. A menos que sea de una revista o publicación de confianza, sé escéptico.

Comprueba las respuestas de Claude o ChatGPT, incluso si se basan en datos específicos que tú proporciones. Un error común es pensar que si subes una transcripción de una llamada, una entrevista o alguna otra información confidencial a Claude o ChatGPT, no se producirán alucinaciones. No es cierto. Mi amigo de CRO fraccional reserva tiempo para hacer su seguimiento asistido por IA inmediatamente después de que su cliente llame para que pueda detectar fácilmente las alucinaciones mientras la llamada está fresca en su mente. Consejo profesional: Reducirás las alucinaciones si le pides a la IA que solo extraiga del documento que proporcionaste, no de su información general. Pero a menudo, tienes que preguntar dos o tres veces.

Dale permiso a la IA para que no sepa algo. Después del fiasco de la investigación del libro, empecé a pedirle a Claude que no se inventara cosas solo para complacerme. Según la investigación de Anthropic y mi experiencia anecdótica, ¡esto ayuda!

Asegúrate de que todos en tu empresa sepan cuánto alucina GenAI. Me muevo en los mismos círculos que muchos directores ejecutivos de tecnología y evangelistas de la IA, y apostaría a que la mayoría de ellos se sorprenderían al saber que la IA alucina el 20 % de las veces. Me sorprendería que tu jefe lo supiera. Este año te van a presionar para que uses la IA para «hacer más con menos» (*bostezo*). Asegúrate de que los que mandan conozcan las desventajas.

Invierte en experiencia en el campo. La mejor manera de detectar las tonterías de la IA es tener experiencia en el tema en cuestión. En este caso, ¡las miles de horas que he perdido animando a los New York Giants por fin han valido la pena!

Cuando se utiliza correctamente, la IA puede ser una herramienta maravillosa para escritores, especialistas en marketing y creativos, ya que nos permite automatizar el trabajo inútil y centrarnos en contar grandes historias. Pero si bajas la guardia, es como jugar a la ruleta rusa con tu reputación y tu carrera.

Cómo pueden los escritores ganar la guerra de contenidos de la IA, antes de que sea demasiado tarde:

En otro artículo, Joe Lazer afirma que las empresas tecnológicas quieren que nos volvamos apáticos ante el uso de la IA en la creación de contenidos. Podemos empezar a contraatacar con una nueva norma sencilla: Revela cómo utilizaste la IA generativa en cada publicación. Como explica en el post:

“Creo que estamos a punto de ver cómo Internet se divide en dos. Por un lado, las plataformas sociales heredadas de hoy en día, infestadas de IA. Por otro lado, un renacimiento de marcas de medios de comunicación de nicho, pequeñas y basadas en la personalidad, a las que la gente acude en masa porque son claramente humanas, dirigidas por personas reales en las que los lectores pueden confiar.

Plataformas como Substack están proporcionando la infraestructura para estas nuevas marcas de medios, y como escritores, una de las mejores maneras de indicar a los lectores que somos humanos es revelar cómo usamos la IA generativa (si es que la usamos). Después de todo, las granjas de basura de IA en el lado oscuro de Internet no van a hacer lo mismo. De nuevo, esto no significa que no puedas utilizar la IA generativa. Solo significa que debes ser transparente con tu audiencia sobre cómo la utilizas.”

Sobre The Storytelling Edge

Este es un boletín para personas que quieren aprender a contar mejores historias y crear una audiencia en un mundo de IA. Su propietario es Joe Lazer (f. Lazauskas), escritor, investigador y fanático de la narración. Como señala:

“Mi promesa para ti como suscriptor es esta: cada publicación que recibas te ayudará a contar mejores historias, a elaborar una estrategia de contenido más sólida o a pensar en el entorno de los medios de comunicación de una manera nueva. (Lo ideal sería las tres cosas).”

Nota: Agradecemos a Joe Lazer su colaboración en este artículo, que es una adaptación (y ampliación) del suyo en inglés:

La capacidad de la inteligencia artificial para engañar a las personas, haciéndolas creer que están interactuando con una persona real en lugar de con un sistema automatizado, se debe a varios factores. Uno de los principales es el avance en la calidad de los modelos de lenguaje, como GPT, que son capaces de generar texto de manera coherente, fluida y contextualmente relevante. Estos modelos pueden imitar patrones de conversación humana, adaptándose al tono, al vocabulario y a las respuestas esperadas según el contexto.

Cuando una IA interactúa en una conversación, puede construir respuestas que parecen naturales y auténticas, lo que hace difícil para el usuario distinguir entre una persona y un sistema. La IA también tiene la capacidad de aprender de grandes volúmenes de datos textuales y de ajustarse a diferentes estilos de comunicación. Si bien aún existen limitaciones, como la falta de comprensión profunda o la incapacidad de expresar emociones genuinas, el texto generado por IA puede ser sorprendentemente convincente.

El hecho de que no todos los usuarios sean conscientes de cómo funciona la IA o de las señales sutiles que podrían indicar que no están interactuando con una persona real también contribuye al engaño. Muchas personas, especialmente aquellas que no están familiarizadas con la tecnología, pueden no notar detalles como una falta de personalidad consistente, respuestas demasiado perfectas o la incapacidad de seguir un hilo de conversación complejo a largo plazo.

Además, la IA puede ser utilizada de manera maliciosa en contextos como el phishing o la manipulación de información, donde se diseñan respuestas que buscan influir en las decisiones de las personas. Si la IA logra engañar al usuario, las consecuencias pueden ser desde simples malentendidos hasta fraudes más graves.

Es importante que los usuarios sean conscientes de las tecnologías actuales y mantengan un escepticismo saludable al interactuar con sistemas automatizados, especialmente en entornos donde la veracidad de la información y la seguridad personal están en juego.